El archivo que deben tener todas las webs

Una de las principales vías de los negocios para llevar tráfico a sus webs a día de hoy es el SEO. Visitantes que llegan al sitio a través de los diferentes buscadores tras introducir determinadas palabras clave. Entre ellos, por supuesto, destaca Google.

Pero esto, por supuesto, no es nada fácil; menos aún si pensamos en la enorme competencia que hay en prácticamente todos los sectores. Por ello, la web debe estar optimizada por completo, y uno de los primeros pasos para lograrlo es tener un archivo Robots txt perfecto.

¿Qué es?

Como decimos, es uno de los archivos más importantes a nivel de posicionamiento SEO en la propia página. Y para definirlo de forma sencilla, podemos decir que se trata concretamente de la presentación de las webs de cara a los buscadores, y que informan a los rastreadores de las urls que deben rastrear y de las que no.

¿Para qué sirve?

El principal beneficio de su uso es evitar que la página se sobrecargue del tráfico de rastreadores. Aunque también sirve para restringir determinadas partes del sitio, optimizar el crawl budget (presupuesto de rastreo) y para ocultar archivos multimedia o recursos.

¿Qué debe incluir?

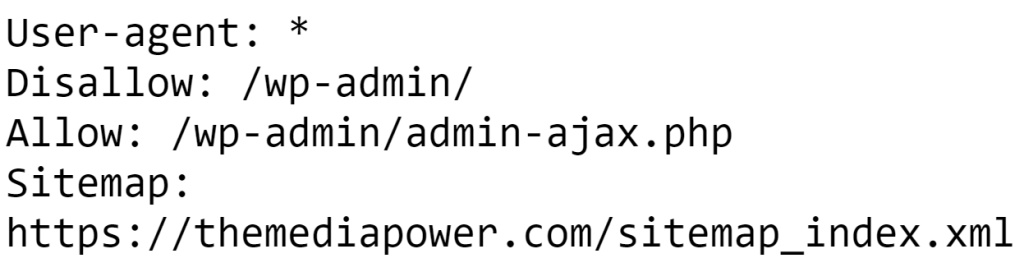

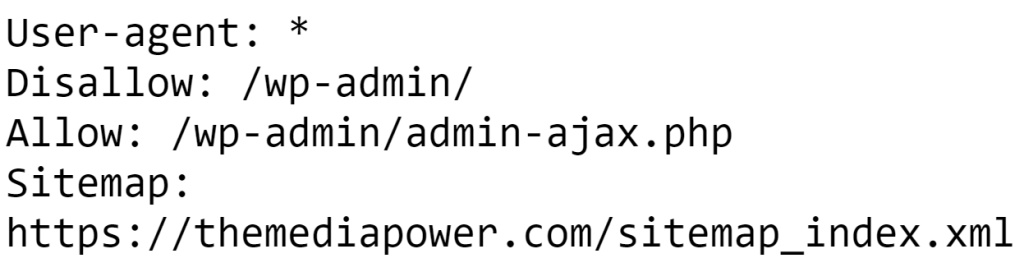

Por lo tanto, lo más importante que debemos incluir son aquellos sitios que queremos que los rastreadores entren y aquellos en los que no. Para ello tenemos a nuestra disposición distintos comandos:

- User-agent. Se usa para indicar para qué buscador son las siguientes instrucciones. En el caso de estar incluido User-agent: * las órdenes son válidas para todos los buscadores.

- Disallow. Nos permite indicar en qué espacios no se deben introducir los rastreadores.

- Allow. Justo lo contrario que el anterior. Nos permite especificar las partes anteriormente marcadas como disallow a las que ahora sí pueden entrar.

Aquí tienes el ejemplo de nuestra propia web:

Robots txt en WordPress

Como suele ocurrir con todos los procesos que queremos llevar a cabo en nuestras webs, existen varios plugins que pueden realizar de forma sencilla la tarea. El más común es SEO Yoast, el cual permite realizar prácticamente cualquier tarea relacionada con el posicionamiento SEO on page. Aunque hay otros muchos que también pueden servir y que hacen un trabajo mucho más específico, centrándose en el archivo. Algunos ejemplos son Robots.txt Editor o WordPress Robots.txt optimization.